编辑|冷猫

谷歌 2017 年提出的 Transformer 架构事实上已经基本垄断了大模型。

不采用 Transformer 架构的大模型已经是少之又少,而采用非 Transformer 架构,还能与主流第一梯队大模型扳手腕的,更是凤毛麟角。

不知道大家是否还有印象,当年有一个尝试给大模型装上「虫脑」的初创公司,他们的研究人员受到秀丽隐杆线虫的神经结构启发,研发出一种新型的灵活神经网络,也被称为液态神经网络。

这是一个连续时间模型,由多个简单的动态系统组成,这些系统通过非线性门相互调节。这种网络的特点是时间常数可变,输出通过求解微分方程得到。它在稳定性、表达能力和时间序列预测方面都优于传统模型。

除此以外,液态神经网络的另一个特点是规模小得多,在 2024 年该架构就实现了 1.3B 大小的模型部署,但彼时尚未能与主流大模型一拼高下。

提出液态神经网络架构,并且做出 Liquid Foundation Models(LFM)大模型的,是由 MIT 计算机科学和人工智能实验室 CSAIL 孵化,成立于 2023 年 3 月的初创公司 Liquid AI。

就在刚刚,Liquid AI 又一次在 LFM 模型上放大招。他们正式发布并开源了 LFM2.5-1.2B-Thinking,一款可完全在端侧运行的推理模型。

Liquid AI 声称,该模型专门为简洁推理而训练;在生成最终答案前,会先生成内部思考轨迹;在端侧级别的低延迟条件下,实现系统化的问题求解;在工具使用、数学推理和指令遵循方面表现尤为出色。

该模型在手机上仅需 900 MB 内存 即可运行,同时在同等规模模型中实现了最快的推理速度和最佳的质量表现。两年前还必须依赖数据中心才能完成的能力,如今已经可以在你的口袋里离线运行。

Leap 开源链接:https://leap.liquid.ai/models

HuggingFace 链接:https://huggingface.co/LiquidAI/LFM2.5-1.2B-Thinking

优于 Transformer 的性能

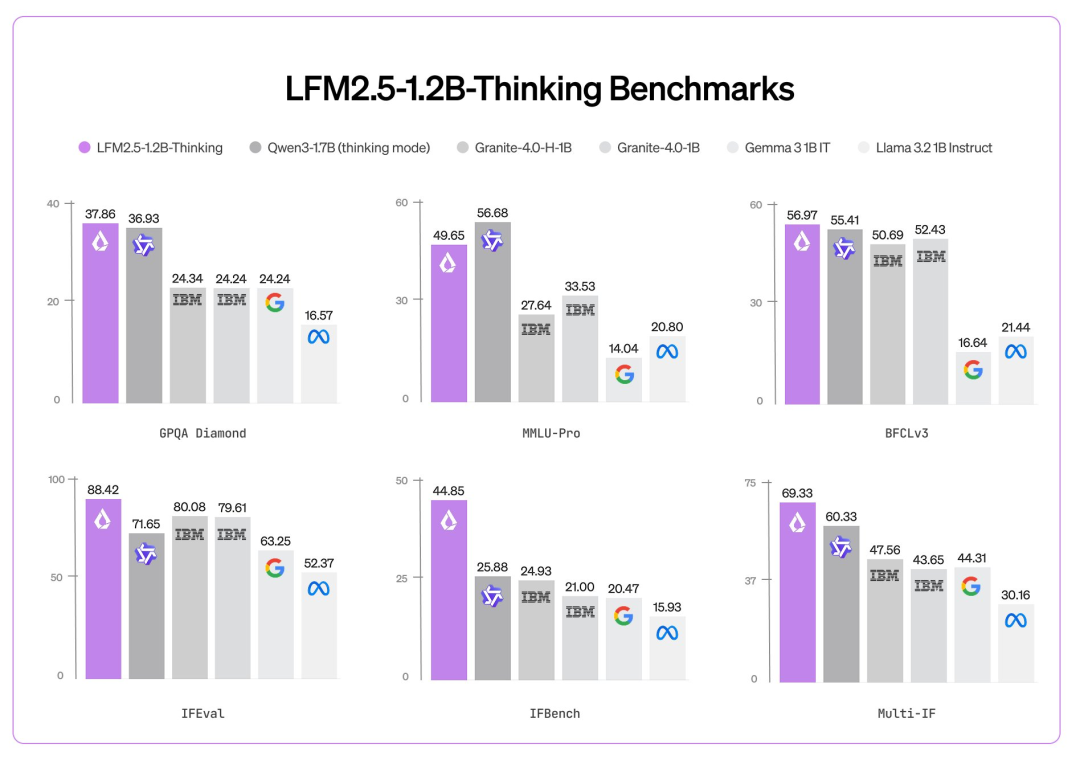

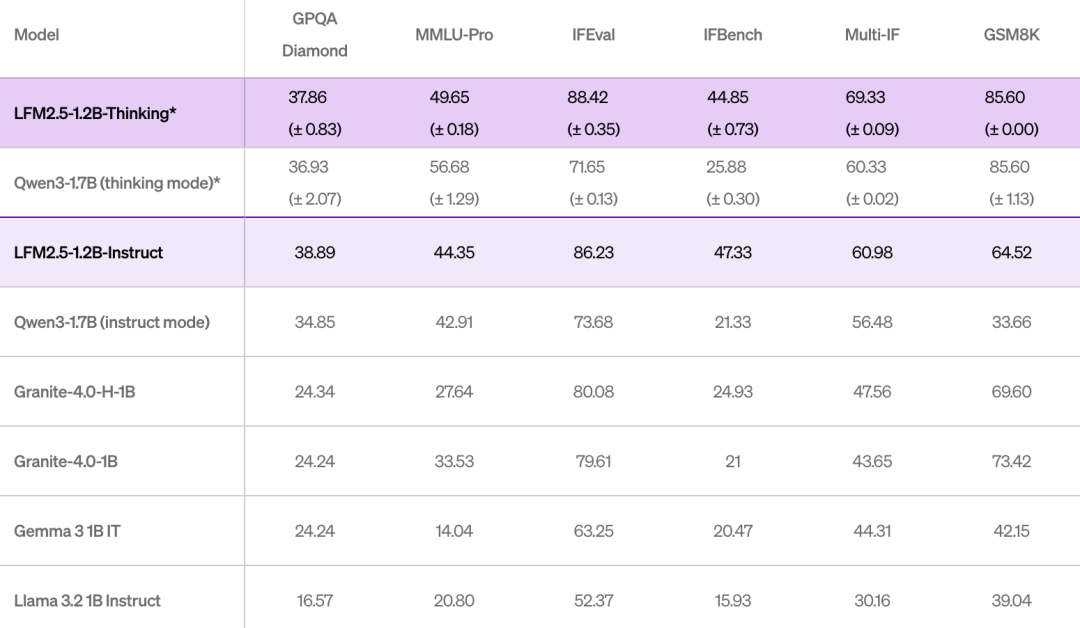

与 Liquid AI 之前的模型 LFM2.5-1.2B-Instruct 相比,LFM2.5-1.2B-Thinking 在三项能力上实现了显著提升:

数学推理:在 MATH-500 上从 63 提升至 88

指令遵循:在 Multi-IF 上从 61 提升至 69

工具使用:在 BFCLv3 上从 49 提升至 57

在大多数推理基准测试中,LFM2.5-1.2B-Thinking 的表现已与甚至超过 Qwen3-1.7B,尽管其参数量少了 约 40%。

同时,该模型在质量与测试时计算效率之间取得了良好平衡:与 Qwen3-1.7B(思考模式) 相比,它在使用更少输出 token 的情况下,依然提供了更高的整体性能。

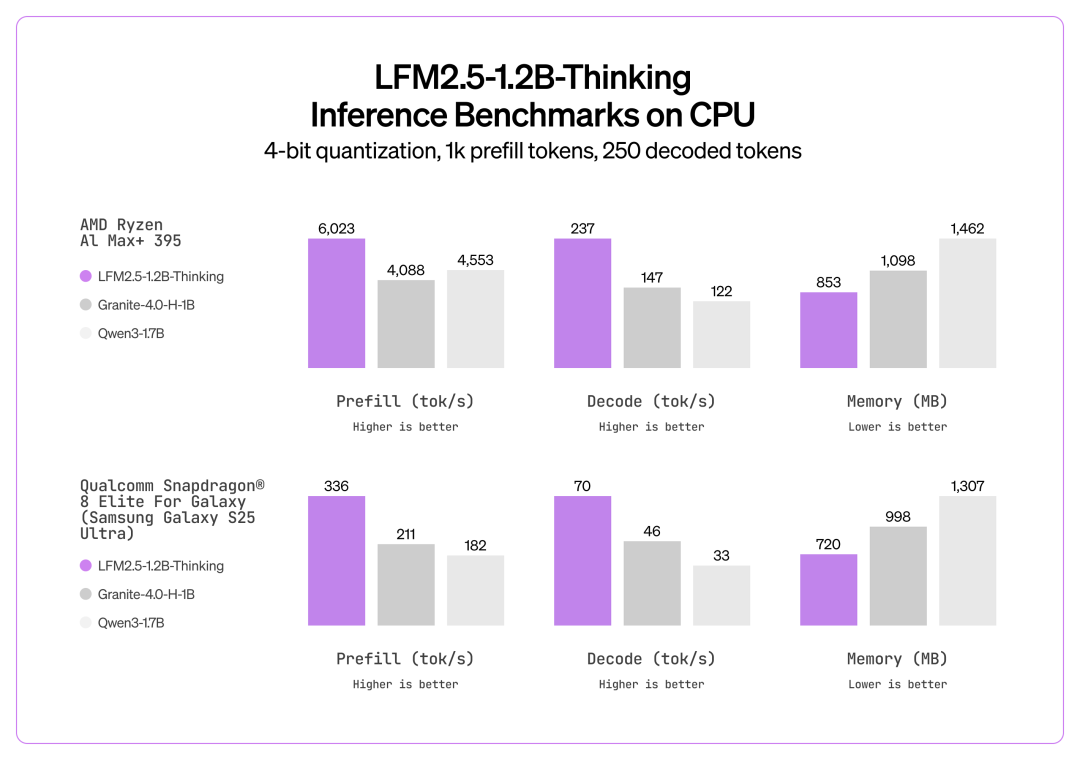

在推理阶段,这一性能差距进一步拉大:LFM2.5-1.2B-Thinking 在推理速度和内存效率两方面,都优于纯 Transformer 模型(如 Qwen3-1.7B)和混合架构模型(如 Granite-4.0-H-1B)。

Liquid AI 表示,LFM2.5-1.2B-Thinking 在 智能体式(agentic)任务和高推理强度任务(例如工具使用、数学、编程)中表现尤为突出。当模型需要规划一系列工具调用、验证中间结果并动态调整解题策略时,其生成的推理轨迹能够发挥实际价值。而在对话交互和创意写作等场景下,则更推荐使用 LFM2.5-1.2B-Instruct。

训练细节

要构建能力强的小型推理模型,关键在于:在知识容量有限的前提下,通过多步推理来弥补能力,同时又要保持答案简洁,以满足端侧低延迟部署的需求。

此前在 LFM-1B-Math 上的实验表明,在中期训练阶段引入推理轨迹,有助于模型内化「先推理,再作答」的模式。随后,基于合成推理轨迹进行的监督微调(SFT),进一步让模型能够稳定地产生思维链,而无需依赖特定格式的奖励设计。

然而,SFT 并不能解决推理模型中的一个常见问题:模型可能陷入重复文本模式,迟迟无法得出结论。这种行为通常被称为 「doom looping」(死循环式生成)。为此,Liquid AI 采用了一种相对直接的缓解方法:

在偏好对齐阶段,基于 SFT 模型生成了 5 个温度采样候选和 1 个贪婪解码候选;当不存在循环时,选择由 LLM 评判得分最高的作为正样本、得分最低的作为负样本;一旦出现循环生成,则无论评判得分如何,直接将出现循环的候选作为负样本。

在 RLVR 阶段,进一步在训练早期引入了基于 n-gram 的重复惩罚,以抑制循环生成行为。

通过这些策略,模型在保持推理能力的同时,显著降低了陷入无效循环的风险。

这一方法在一个具有代表性提示词的数据集上,将死循环生成的比例从 15.74%(中期训练阶段) 显著降低到了 0.36%(RLVR 阶段),效果非常直接且稳定。

Liquid AI 的 RL 训练流水线核心采用的是无 critic、类 GRPO 方法。整体实现是 reference-free 的,并结合了多项训练技巧,包括:

非对称比例裁剪(asymmetric ratio clipping)

对零方差提示组的动态过滤

超长样本掩码(overlong-sample masking)

不进行优势归一化(no advantage normalization)

截断的重要性采样(truncated importance sampling)

RL 方法的

RL 方法的简化示意图:最终发布的 checkpoint 是一个合并模型,其「家族树」中包含 25 个不同的子 checkpoint。

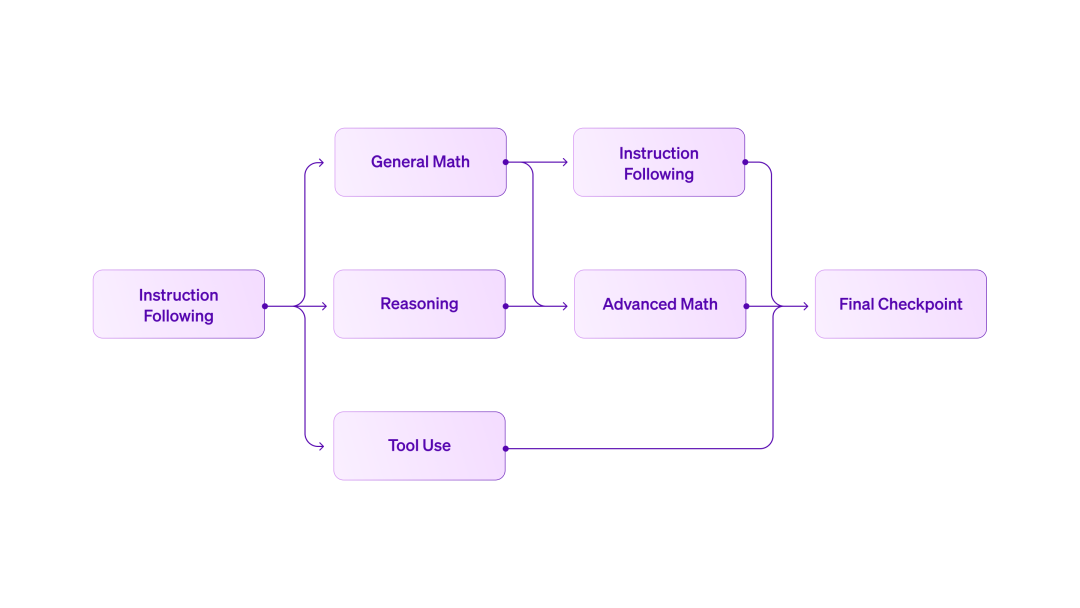

Liquid AI 采用了一种高度并行的 Curriculum RL 训练框架,先以指令跟随的 RLVR 作为基础起点,再分叉出面向推理、数学、工具使用等不同领域的专项 checkpoint。

这种并行结构不同于传统的「单模型、多任务同时训练」方式,往往会引发能力相互干扰。

Curriculum RL 提供了更精细的控制粒度:每个领域的模型都可以独立优化,拥有各自的奖励设计、超参数和评估标准。随后,我们在不同阶段进行迭代式模型合并,生成在多种能力之间更均衡的新 checkpoint。

实践表明,模型合并在保留整体性能的同时,能够有效吸收专项能力提升,是一条可行且可扩展的通用 RLVR 训练路径。

此外,Liquid AI 正在全力拓展 LFM 系列模型的生态系统和合作伙伴。

LFM2.5-1.2B-Thinking 实现了开箱即用支持,兼容最流行的推理框架,包括 llama.cpp、MLX、vLLM 和 ONNX Runtime。所有框架均支持 CPU 和 GPU 加速,覆盖 Apple、AMD、Qualcomm 和 Nvidia 等硬件。

为了确保 LFM2.5 系列 能够在各种场景下高效运行,Liquid AI 正在快速扩展软硬件生态系统,并欢迎 Qualcomm Technologies, Inc.、Ollama、FastFlowLM 和 Cactus Compute 作为新的合作伙伴加入。

LFM2.5-1.2B-Thinking 在不同硬件设备上的长上下文推理表现。

LFM2.5-1.2B-Thinking 可能只是个起点,但它已经证明了一件事 ——Transformer 并非唯一解,小而强的端侧推理模型或许有更优解。

更重要的是,运行推理模型的门槛越来越低,让更多设备激发 AI 潜能,不论如何,都是一件美事。

参考链接:https://www.liquid.ai/blog/lfm2-5-1-2b-thinking-on-device-reasoning-under-1gb#training-recipe